- meteoblue é um dos melhores provedores de previsão do tempo para a previsão da temperatura do ar em 24 horas.

- meteoblue demonstra a maior precisão de previsão de 12 horas.

- O modelo meteoblue Learning MultiModel (mLM) usado para a previsão de temperatura operacional tem o melhor desempenho, seguido por um MOS padrão e os modelos puros.

- A previsão do mLM supera a previsão do modelo de reanálise ERA5, que é a melhor de todos os outros modelos meteorológicos numéricos brutos selecionados.

- Em escala global, as previsões de temperatura têm a maior previsibilidade em pequenas ilhas oceânicas e ao longo de costas sem gelo.

- A previsibilidade diminui com a topografia cada vez mais complexa e com o aumento da distância do mar.

A temperatura do ar é uma das variáveis essenciais da meteorologia, e ser capaz de prevê-la traz muitos benefícios. Em tempos de mudança climática, as temperaturas globais estão subindo. O número de ondas de calor está aumentando, o que pode ter consequências importantes para a produção agrícola, para a população urbana e muitos outros fenômenos. Para casos como esses, uma previsão precisa dessa variável meteorológica é de fundamental importância.

Nesta seção, é apresentada uma visão geral dos estudos de verificação que examinam a precisão da previsão da temperatura a 2m acima do solo. Foram realizados vários estudos de verificação, nos quais a precisão de diferentes previsões de modelos puros, provedores de serviços meteorológicos, diferentes abordagens de modelos e medições horárias foram comparadas. Além disso, a variabilidade regional dos erros do modelo foi examinada. Ao oferecer um resumo de nossas descobertas, queremos garantir que nossos clientes possam compreender totalmente a previsão de temperatura e seus aspectos de precisão.

Comparação de diferentes abordagens de modelos (2017)

Neste estudo, a precisão de diferentes abordagens de modelo é comparada - dados de previsão de 5 modelos meteorológicos brutos diferentes, dados de previsão calculados pelo meteoblue Learning MultiModel (mLM) e estatísticas de saída do modelo (MOS), e o modelo de reanálise ERA5. A análise foi feita para 2017 e parcialmente para setembro e outubro de 2018.

| Abordagem de modelo | MAE [K] |

|---|---|

| meteoblue Learning MultiModel (mLM) | 1.2 K |

| Estatísticas de saída do modelo (MOS) | 1.5 K |

| Modelo de reanálise ERA5 | 1.5 K |

| 5 modelos diferentes de previsão do tempo (Brutos) | 1.7 - 2.2 K |

A tabela a seguir mostra o erro médio absoluto (MAE) em Kelvin para as diferentes abordagens de modelo. A abordagem mLM demonstrou o menor MAE, seguida pela MOS e pela ERA5. Essas abordagens de modelo têm um desempenho melhor do que os modelos puros.

Além disso, podemos observar que o desempenho do modelo normalmente diminui com o aumento das horas de previsão (veja a figura abaixo). A precisão da temperatura do ar de 2 m ao usar o mLM está dentro de 1,2 K para a previsão de 24 horas e de 2,0 K para a previsão de 6 dias. Com base na tabela acima, isso implica que a previsão de 24 horas do mLM é tão boa quanto a previsão de 6 dias das previsões do modelo puro.

![MAE [K] como uma função das horas de previsão para o mLM para dias de análise única e a média (preto).

O erro de previsão de 24 horas para o MOS (azul) e os modelos puros (vermelho) são mostrados adicionalmente.](/assets/images/graphics/mlm-and-raw-models.png)

A distribuição espacial dos erros do modelo (veja os mapas abaixo) destaca o fato de que o mLM supera o o melhor modelo histórico de reanálise ERA5. Em geral, os modelos puros, como o GFS, têm desempenho pior do que as abordagens de modelo baseadas em métodos de pós-processamento nos quais as medições horárias locais são consideradas.

![MAE [K] da temperatura do ar de 2 m da reanálise ERA5 (não disponível como previsão) usada para análise histórica de longo prazo.

A verificação é baseada em todos os dados horários do ano de 2017.](/assets/images/graphics/ERA5_MAE_page4.png)

![MAE [K] da temperatura do ar de 2 m do modelo múltiplo de aprendizagem (MLM) do meteoblue

usado na previsão do tempo operacional. A verificação é baseada em todos os dados horários de setembro e outubro de 2018.](/assets/images/graphics/mLM_MAE_page4.png)

![MAE [K] da temperatura do ar de 2 m da saída do modelo crudo, conforme calculado pelo GFS.

A verificação é baseada em todos os dados horários de 2017.](/assets/images/graphics/GFS_MAE_page4.png)

Comparação de diferentes modelos globais (2018)

Um estudo de verificação adicional para avaliar o desempenho de diferentes modelos globais foi realizado em um estudo de bacharelado (Fessler, 2019). A Previsão de temperatura do ar de 2m para 24 horas do ano de 2018 dos modelos de previsão NEMS, GFS05, MFGLOBAL, GEM e ICON foram comparadas às medições horárias de mais de 8.000 estações da OMM (Organização Meteorológica Mundial) e do GDAS (Sistema Global de Assimilação de Dados) da NOAA (National Oceanic and Atmospheric Administration), distribuídos em todo o mundo. Além disso, dados históricos do modelo de reanálise ERA5 foram incluídos, nos quais várias métricas de erro estatístico foram calculadas e comparadas. Além disso, foram examinados os padrões globais de variabilidade da precisão.

Comparação de modelos puros

| Modelo | MAE [K] | MBE [K] |

|---|---|---|

| ERA5 | 1.5 | 0.2 |

| NEMSGLOBAL | 2.2 | 0.1 |

| GFS05 | 2.3 | 0.2 |

| MFGLOBAL | 2.3 | -0.1 |

| GEM | 2.4 | -0.7 |

| ICON | 2.0 | -0.1 |

A comparação simples de erros permite a avaliação do desempenho entre diferentes modelos. As conclusões a seguir (veja a tabela abaixo) confirmam os resultados do estudo anterior. O modelo de reanálise ERA5, com um MAE de 1,5 K, supera todos os modelos puros examinados neste estudo, seguido pelo ICON e pelo NEMSGLOBAL. O ERA5, o NEMSGLOBAL e o GFS05 tendem a prever a temperatura mais alta do que realmente ocorre, enquanto o MFGLOBAL, o GEM e o ICON preveem a temperatura como mais baixa do que a descrita pelas medições.

Em todas as estações meteorológicas, a ERA5 tem o melhor desempenho e o menor MAE (veja a figura abaixo).

![MAE [K] para cinco modelos numéricos de previsão do tempo e um modelo de reanálise para

todo o ano de 2018 com base em mais de 8.000 estações WMO.](/assets/images/graphics/model_comparison_MAE.png)

Análise espacial

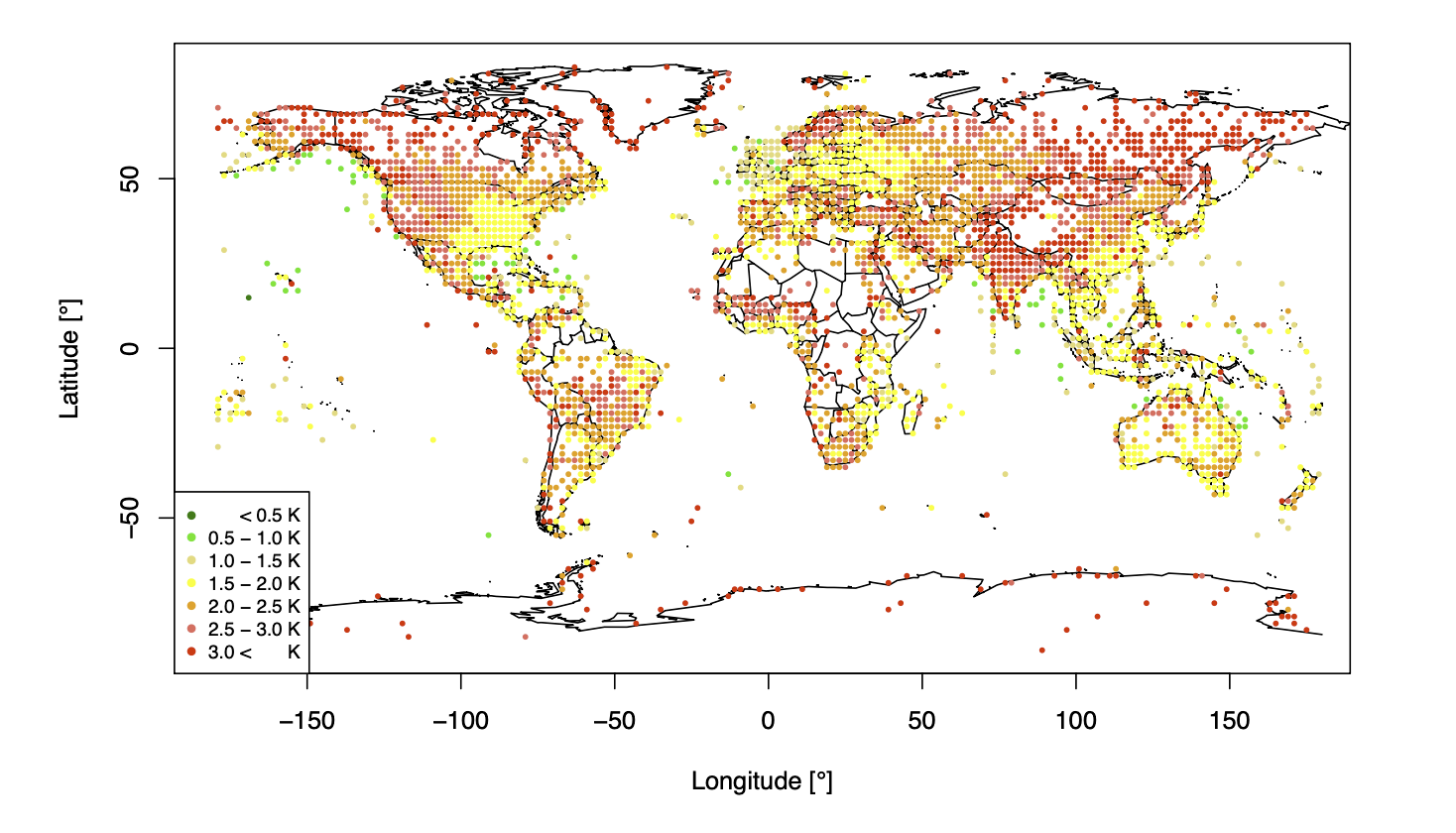

A distribuição espacial do MAE para o modelo de reanálise ERA5 e NEMS é visualizada nos mapas mundiais a seguir. Para evitar a sobreposição de pontos de plotagem de diferentes estações, o globo foi dividido em células de grade de modelo com uma resolução horizontal de 2°. Em outras palavras, o MAE de todas as estações em uma das células da grade foi primeiro mesclado e depois plotado no centro do campo da grade. A distribuição principal do erro do modelo entre os dois modelos é comparável, no entanto, observe que o NEMS tem uma faixa de erro deslocada. Em geral, podemos identificar erros mais altos nas Montanhas Rochosas, na Índia, na China e no Brasil. Um bom desempenho pode ser observado no norte da Europa, América do Norte, Austrália, Rússia Ocidental e África.

![Distribuição espacial do MAE [K] para NEMS (parte superior) e ERA5 (parte inferior),

calculado para medições horárias do ano de 2018 de mais de 8.000 estações meteorológicas em todo o mundo.](/assets/images/graphics/worldmap-era5-page7.png)

A previsão da temperatura do ar tem a maior precisão em pequenas ilhas oceânicas e ao longo de costas sem gelo. Nessas regiões, a temperatura do ar é fortemente influenciada pela temperatura da superfície do mar. A alta precisão e previsibilidade na Europa e na América do Norte podem ser explicadas pelo fato de que os modelos de previsão do tempo foram desenvolvidos nessas regiões. Outro fato que vale a pena mencionar (e não abordado nos estudos) é que a temperatura do ar é normalmente simulada de forma pior no inverno do hemisfério norte do que no inverno. Além disso, os resultados mostram que a precisão diminui em regiões com topografia complexa, como as Montanhas Rochosas, o Himalaia ou os Andes, e com o aumento da distância do mar. Portanto, as regiões continentais e as regiões com alta elevação são normalmente simuladas de forma pior do que as regiões marítimas e de baixa elevação.

Comparação de provedores (2021)

Neste estudo, os desempenhos das previsões de vários provedores meteorológicos foram comparados com a previsão do meteoblue. Os desempenhos dessas previsões foram verificados com 475 medições METAR em todo o mundo. Para a análise, foi usada a previsão horária de 12 a 35 horas criada às 12:00 UTC. Essa verificação foi realizada para o ano de 2021. A tabela a seguir mostra que a previsão do meteoblue está entre os três melhores desempenhos, subestimando apenas ligeiramente a temperatura do ar.

| Fornecedor | MAE [°C] | MBE [°C] | |

|---|---|---|---|

| 2 | meteoblue | 1.29 | -0.16 |

| 1 | Fornecedor_D | 1.26 | -0.02 |

| 3 | Fornecedor_F | 1.48 | -0.21 |

| Fornecedor_C | 1.61 | -0.52 | |

| Fornecedor_G | 1.73 | -0.03 | |

| Fornecedor_B | 1.71 | -0.38 | |

| Fornecedor_H | 2.03 | -0.23 |

A comparação do MAE para diferentes horizontes de tempo de previsão (consulte a tabela abaixo) mostra a típica redução no desempenho da previsão com o aumento das horas de previsão (que já foi mencionada na seção acima). Quando se trata da previsão de 12 horas, meteoblue é o mais preciso. meteoblue é o segundo mais preciso para os dias de previsão de 1 a 3.

| Fornecedor | Dia 0 (0-11 h) |

Dia 1 (12-35 h) |

Dia 2 (36-47 h) |

Dia 3 (48-71 h) |

||||

|---|---|---|---|---|---|---|---|---|

| meteoblue | 0.71 | 1 | 1.29 | 2 | 1.37 | 2 | 1.44 | 2 |

| Fornecedor_D | 1.16 | 3 | 1.26 | 1 | 1.34 | 1 | 1.43 | 1 |

| Fornecedor_A | 1.28 | 3 | 1.24 | - | - | |||

| Fornecedor_F | 1.36 | 1.48 | 1.56 | 1.65 | ||||

| Fornecedor_C | 1.54 | 1.61 | 1.68 | 1.92 | ||||

| Fornecedor_G | 1.56 | 1.73 | 1.77 | - | ||||

| Fornecedor_B | 1.68 | 1.71 | - | - | ||||

| Fornecedor_H | 1.95 | 2.03 | 2.11 | 2.29 | ||||